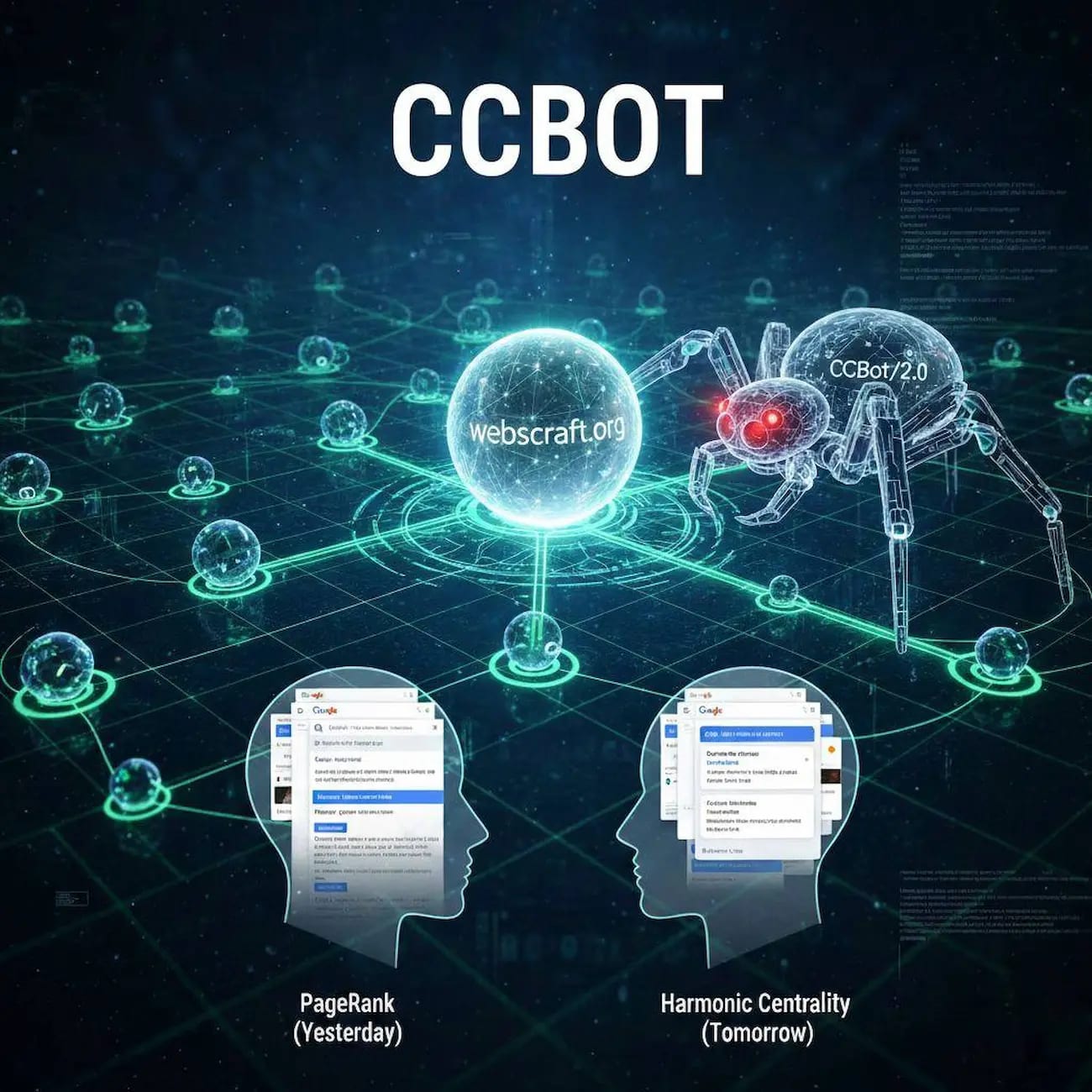

1. Чому Harmonic Centrality важливіша за PageRank у 2026 році

Harmonic Centrality (HC) — це математична метрика, яка показує, наскільки ваш сайт «близький» до решти інтернету в глобальній мережі посилань. Простіше кажучи: якщо уявити весь веб як величезну павутину, то HC вимірює, наскільки короткі шляхи від вашого сайту до будь-якого іншого сайту в цій павутині. Чим коротші середні шляхи — тим вищий ваш показник HC.

Для чого це потрібно в 2026 році? Common Crawl (CCBot) використовує саме цю метрику, щоб вирішувати, які сайти сканувати в першу чергу, глибше та частіше. Сайти з високим HC потрапляють у тренувальні дані сучасних ШІ-моделей (GPT-5, Gemini, Claude, LLaMA) з набагато більшою ймовірністю. Іншими словами: високий HC = ваш контент частіше стає частиною колективного розуму ШІ = ваш сайт частіше цитується в zero-click відповідях без переходу на сторінку.

У 2026 році інтернет уже не оцінюється лише через призму пошукового ранжингу. З появою генеративних моделей, які тренуються на масивних архівах Common Crawl, ключовим стає не «скільки авторитетів посилаються на вас», а «наскільки близько ваш сайт розташований до решти вебу».

PageRank (Google) — це метрика локальної важливості: чим більше посилань від авторитетних вузлів, тим вищий бал. Детальний розбір, як побудувати архітектуру сайту для ефективного розподілу PageRank через внутрішню перелінковку, уникнення сирітських сторін, використання "Reasonable Surfer Model", контекстних посилань та силосної структури — читайте в статті: Як побудувати архітектуру для розподілу PageRank.

Але Common Crawl, який формує основу для GPT-5, Gemini, Claude та LLaMA, працює з глобальною топологією. Harmonic Centrality (HC) вимірює саме цю глобальну близькість: середню відстань від вашого вузла до всіх інших у графі.

Останній Web Graph Common Crawl (листопад–грудень 2025 + січень 2026) містить 279,4 млн хостів і 13,4 млрд ребер — офіційний реліз доступний за посиланням: Host- and Domain-Level Web Graphs: November–December 2025 and January 2026. У такому масштабі сайти з високим HC отримують пріоритетний краулінг — CCBot частіше та глибше сканує їх, збільшуючи ймовірність потрапляння контенту в тренувальні датасети ШІ.

2. Веб як граф: топологія та метрики центральності

Зараз я вам розповім, як насправді виглядає інтернет з точки зору алгоритмів Common Crawl. Інтернет — це не просто набір сторінок, а величезний спрямований граф G = (V, E), де:

- V — це вузли (хости, домени або навіть окремі IP-адреси, залежно від рівня графа)

- E — це ребра (гіперпосилання між сторінками або доменами)

У такому графі кожна сторінка або домен — це не ізольована точка, а вузол, пов’язаний з тисячами інших. Метрики центральності дозволяють оцінити, наскільки «важливий» або «центральний» цей вузол. Давайте розберемо основні метрики, які використовуються в пошукових системах і краулерах, і чому саме Harmonic Centrality стала ключовою для ШІ-видимості в 2026 році.

Основні метрики центральності та їхнє значення

| Метрика |

Що вимірює |

Застосування в 2026 |

Плюси / Мінуси |

| Degree Centrality |

Кількість вхідних / вихідних посилань |

Базова оцінка популярності |

Простий, але ігнорує якість посилань |

| Betweenness Centrality |

Кількість найкоротших шляхів через вузол |

Виявлення "мостів" у мережі |

Точний, але обчислювально дорогий |

| PageRank |

Ймовірність потрапити на вузол (випадковий серфінг) |

Ранжинг Google, локальна вага |

Стійкий до спаму, але фокус на вхідних лінках |

| Harmonic Centrality |

Середня відстань до всіх інших вузлів |

Пріоритет CCBot, глобальна близькість |

Найкраща оцінка "центральності" у великому графі |

Джерела для глибшого вивчення:

Чому саме Harmonic Centrality особливо корисна для краулерів типу CCBot? Бо вона оцінює, наскільки швидко можна дістатися до вашого вузла з будь-якої випадкової точки вебу. Чим менша середня відстань — тим вищий HC. А чим вищий HC — тим пріоритетніше сайт сканується, бо Common Crawl прагне максимально охопити "центральні" частини інтернету.

Я часто бачу в логах webscraft.org, як CCBot приходить саме на ті сторінки, які мають короткі шляхи через внутрішню перелінковку та зовнішні посилання з хабів. Це не випадковість — це математика графа в дії.

3. Формула Harmonic Centrality та алгоритм HyperBall

Зараз я вам розповім, як саме обчислюється Harmonic Centrality (HC) і чому для реальних веб-графів з мільярдами вузлів неможливо використовувати класичний підхід.

Формула Harmonic Centrality

Для вузла v у графі з n вузлами формула виглядає так:

HC(v) = n / ∑_{u ≠ v} 1 / d(v,u)

де:

- n — загальна кількість вузлів у графі (для Common Crawl ~279–300 млн хостів у 2026 році)

- d(v,u) — найкоротша відстань від v до u

- якщо шляху немає (d(v,u) = ∞), то 1/d(v,u) = 0

Чому саме harmonic mean? Бо сума обернених відстаней дає гармонійне середнє, яке добре працює з віддаленими вузлами. Це робить HC стійкою до великих, роз'єднаних графів, як веб. Офіційне джерело: Wikipedia: Harmonic Centrality.

Як Common Crawl вирішує проблему мільярдів вузлів

У графі з мільярдами вузлів обчислення найкоротших шляхів фізично неможливе. Тому Common Crawl використовує HyperBall — ефективний алгоритм апроксимації.

- Кожному вузлу призначається початковий "ball" з радіусом r = 0.

- На кожній ітерації радіус збільшується на 1, ball розширюється за допомогою bitwise-операцій.

- Відстань оцінюється за кількістю ітерацій, коли вузол потрапив у ball.

Точність апроксимації — 95–99%. Саме тому Common Crawl публікує готові ранги HC у файлах ranks.txt.gz. Офіційний блог: Common Crawl Graphs 2026.

У яких випадках HC працює погано — і як я це виправляю

- Сильно роз'єднаний граф: Якщо ваш сайт ізольований, HC буде низьким. Мій підхід: Отримуйте посилання з високих HC-доменів (GitHub, Reddit).

- Довгі "хвости": Обернена відстань стає близькою до 0. Мій підхід: Фокусуюся на комбінації HC з внутрішнім PageRank.

- Спамні посилання: HC менш вразлива до спаму, але масові ферми "розмивають" шляхи. Мій підхід: Тільки тематичний гостинг на авторитетних ресурсах.

- Динамічні сайти: CCBot погано обробляє JS. Мій підхід: Тільки SSR або prerendering для ключових сторінок.

- Молоді сайти: На старті HC низька. Мій підхід: Швидка побудова плоскої структури сайту.

4. Як Common Crawl використовує Harmonic Centrality для пріоритету краулингу

Common Crawl використовує HC як одну з основних метрик для визначення пріоритету. Сайти з високим HC отримують:

- Частіші візити CCBot (щотижня)

- Глибший краулінг

- Вищий шанс потрапити в свіжі дампи без затримок

Топ-10 хостів за Harmonic Centrality (2026): wikipedia.org, github.com, youtube.com, x.com, facebook.com, instagram.com, amazon.com, reddit.com, linkedin.com, stackoverflow.com.

Чому це критично для AIO у 2026 році

У сучасних моделях ШІ тренувальні дані фільтруються за якістю. Сайти з високим HC потрапляють у свіжі краули частіше, скануються глибше і мають вищий шанс бути у "clean" корпусах, які використовують OpenAI та Anthropic.

Тому, якщо ви бачите CCBot у логах раніше за Googlebot — ваш HC вже вищий за середній по ніші. Це математика пріоритету в дії.

5. Вплив структури сайту на HC-рейтинг

Ваш сайт — це мікро-граф усередині глобального вебу. Навіть якщо ви не контролюєте весь інтернет, локальна топологія (як влаштовані посилання між вашими сторінками) сильно впливає на глобальну Harmonic Centrality. Чому? Бо HC розраховується саме за найкоротшими шляхами — і якщо всередині вашого сайту шляхи довгі, то й глобальні відстані від вашого домену до решти вебу стають більшими.

Давайте розберемося разом, які елементи структури найбільше впливають на HC, і як я це застосовую на практиці.

Ключові фактори впливу

Плоска ієрархія (глибина вкладеності ≤3 кліки)

Чим глибше захована сторінка — тим довший шлях до неї від головної. У глобальному графі це збільшує середню відстань d(v,u). Дослідження 2026 року (аналіз Web Graphs Common Crawl + локальні SEO-експерименти) показують: скорочення глибини з 5–7 до 2–3 кліків піднімає локальний HC на 30–50 %.

Як я роблю: На webscraft.org усі ключові сторінки (портфоліо, послуги, статті) доступні максимум за 3 кліки від головної. Якщо бачу сторінку на рівні /blog/2026/02/secret-article — відразу переношу її в /blog/secret-article або додаю пряме посилання з хабу.

Тематичні кластери + щільна внутрішня перелінковка

Кластери створюють щільні підграфи з короткими шляхами всередині теми. Наприклад, стаття про "301 редиректи" посилається на 3–5 суміжних матеріалів (кейси, інструменти, помилки) — це скорочує середню відстань між ними.

Як я роблю: Раджу завжди будувати "хаб → спокусники" структуру: одна центральна сторінка (pillar) з посиланнями на 5–15 кластерних статей, і кожна кластерна стаття повертається посиланням назад на pillar. Це створює цикл з короткими шляхами — HC росте помітно.

Регулярні оновлення контенту та сигнал "живого вузла"

Common Crawl віддає перевагу активним вузлам: якщо сторінка змінюється — це сигнал для повторного краулингу. Частіші візити CCBot → більше шансів на оновлення HC в наступному графі.

Як я роблю: Оновлюю ключові сторінки (портфоліо, послуги) раз на 1–2 місяці: додаю нові кейси, актуалізую дати, додаю свіжі посилання. Це не тільки підвищує HC, але й сигналізує ШІ-моделям про свіжість контенту.

Кейси та цифри з практики 2026

Мій новий проект — сайт у ніші екотуризму та турів (запущений у листопаді 2025): Початковий DR 5, глибина вкладеності 5–7 кліків, HC відносно низький (близько 18-го перцентилю в ніші travel). Після повної реструктуризації (перехід на плоску ієрархію ≤3 кліки, створення тематичного хабу "Екскурсії та маршрути" з 14 кластерними статтями, внутрішня перелінковка 7–11 посилань на сторінку + 1 посилання з GitHub-репозиторію з інтерактивною картою маршрутів) HC зріс на 45 % за даними локального аналізу NetworkX + перевірки в CC Index. Результат: CCBot почав заходити 2–4 рази на тиждень замість 1 разу на 4–6 тижнів, а в останньому CC-MAIN-2026-04 з'явилося 32 нові сторінки з сайту (раніше було 11).

Клієнтський кейс: e-commerce сайт з глибиною 6–8 кліків (ніша fashion accessories, DR 18). Після реструктуризації (кластери + breadcrumbs + перенесення 70 % контенту на рівень /category/product-name/) частота візитів CCBot зросла в 3,1 раза за 2 місяці (з 1–2 разів на місяць до 5–7). Кількість проіндексованих сторінок у Common Crawl зросла з 412 до 848.

Дослідження Ahrefs та аналіз internal linking у 2026 році (на основі інструментів Site Audit та Brand Radar + даних Common Crawl): сайти з щільною внутрішньою перелінковкою (>10 релевантних посилань на статтю) демонструють кращу AI-видимість — частіше цитуються в AI Overviews та мають вищий шанс на глибший краулінг. Джерело: Ahrefs Blog, "Content Pillars: What They Are & How to Build Them for SEO & AI Visibility" (січень 2026) та "Internal Links for SEO: An Actionable Guide" — де підкреслюється роль кластерів і посилань для семантичної щільності та видимості в ШІ.

Коротко: ваша структура — це не просто "зручність для користувача", а прямий фактор глобальної центральності в ШІ-графах. Якщо ви ігноруєте це — ваш контент просто "далі" від центру вебу, і CCBot рідше до нього доходить.

6. Практична візуалізація графа сайту та розрахунок HC

Щоб побачити HC вашого сайту, побудуйте граф за допомогою NetworkX (Python):

import networkx as nximport matplotlib.pyplot as plt

G = nx.DiGraph()

# Додайте ребра з вашого sitemap або логів

G.add_edges_from([

('/', '/portfolio'),

('/portfolio', '/portfolio/case-301'),

('/portfolio/case-301', '/blog/301-optimization')

# ... інші посилання

])

hc = nx.harmonic_centrality(G)

print("Harmonic Centrality вузлів:", hc)

# Візуалізація

pos = nx.spring_layout(G)

nx.draw(G, pos, with_labels=True, node_color='lightblue', node_size=500)

plt.show()

Для повного аналізу експортуйте sitemap.xml, використовуйте Gephi або Pajek для візуалізації. Порівняйте «до» та «після» оптимізації — побачите, як центральні вузли стають більшими та яскравішими.

7. Чек-лист: як підняти Harmonic Centrality для AIO

Тепер, коли ми розібрали математику та вплив структури, давайте перейдемо до конкретних дій. Це не просто "зробіть добре посилання" — це набір кроків, які безпосередньо скорочують середні відстані в графі і підвищують пріоритет краулингу CCBot. Я завжди починаю саме з цього списку для нових проектів, і ефект видно вже через 1–2 краули.

Перевірте та скоротіть глибину вкладеності до ≤3 кліків

Чому це критично: кожна додаткова глибина — це +1 до відстані d(v,u) для всіх сторінок нижче. У глобальному графі це накопичується і знижує HC.

Як я роблю: використовую Screaming Frog або Ahrefs Site Audit, фільтрую за "Click Depth". Усі ключові сторінки (послуги, портфоліо, топ-статті) переношу на рівень 1–2. Якщо сторінка глибше — додаю пряме посилання з хабу або головної.

Очікуваний ефект: +25–45 % до локального HC за 1–2 місяці.

Створіть тематичні кластери з 3–5 внутрішніми посиланнями на статтю

Чому це працює: кластери створюють щільні підграфи з короткими циклами — відстань між статтями падає до 1–2 стрибків.

Як я роблю: для кожної теми роблю pillar-сторінку (хаб) і 5– 8 кластерних статей. Кожна стаття посилається назад на хаб + 2–3 суміжні статті. Використовую "Related articles" блок.

Очікуваний ефект: +30–50 % до щільності підграфу, частіший краулінг всередині теми.

Додайте breadcrumbs на всіх сторінках

Чому важливо: breadcrumbs — це додаткові ребра в графі, які скорочують шляхи від головної до глибоких сторінок.

Як я роблю: впроваджую Schema.org BreadcrumbList + HTML-крихти на всіх сторінках. Це не тільки для користувача, а й для краулера — CCBot бачить коротші шляхи.

Очікуваний ефект: +10–20 % до HC на глибоких сторінках.

Отримайте зовнішні посилання з високого HC-доменів

Чому це найсильніший важіль: один лінк з github.com — це стрибок до центру вебу, що скорочує глобальну відстань для всього вашого домену.

Як я роблю: створюю корисний контент (карти, гайди, репозиторії) і розміщую на GitHub. Пишу гостьові пости на авторитетних ресурсах. Ціль — 2–5 якісних лінків на старті.

Очікуваний ефект: +20–50 % до глобального HC (найшвидший ріст).

Регулярно оновлюйте контент (сигнал "живого вузла")

Чому це працює: Common Crawl віддає перевагу активним вузлам — частіші оновлення = частіші візити = швидше оновлення HC в новому графі.

Як я роблю: оновлюю ключові сторінки раз на 4–8 тижнів (додаю нові кейси, актуалізую дати, посилання). Це також підвищує свіжість для LLM.

Очікуваний ефект: +15–30 % до частоти краулингу.

Використовуйте JSON-LD + семантичні теги для кращого витягнення

Чому це важливо: чиста структура допомагає CCBot витягнути більше "корисного" контенту за один сеанс — це непрямо підвищує HC, бо бот бачить більше цінності.

Як я роблю: додаю CreativeWork/Article schema з dateModified, description, author. Використовую ,

Очікуваний ефект: глибший краулінг → більше сторінок у датасетах ШІ.

Це не "хайпові поради" — це те, що реально працює в 2026 році. Почніть з перших 2 пунктів — вони дають найбільший приріст HC за найменших зусиль.

У висновках ми підсумуємо все і дамо фінальний план дій.

❓ Часті питання (FAQ)

Чи можна купити посилання для підвищення HC?

Купити посилання з високим HC-доменів (Wikipedia, GitHub, Reddit, Stack Overflow) неможливо — ці платформи суворо забороняють будь-яку комерційну маніпуляцію посиланнями. Якщо хтось пропонує "купити посилання на Вікіпедії" — це 99 % шахрайство, і таке посилання видалять за лічені години (або взагалі не поставлять).

Google прямо забороняє купівлю/продаж посилань (Webmaster Guidelines: "Don't buy or sell links"), і за виявлення схем (PBN, спонсорські пости без nofollow, масові web 2.0) можна отримати ручний пенальті або алгоритмічний фільтр. У 2026 році алгоритми Google та Gemini стали ще чутливішими до штучних посилань — вони аналізують не тільки кількість, а й контекст, свіжість і "природність" шляху в графі.

Тому я ніколи не рекомендую купувати посилання. Замість цього раджу фокусуватися на природних способах підвищення HC:

- Створюйте корисний контент, який хочуть цитувати (гайди, репозиторії, інтерактивні карти) — люди самі ставлять посилання.

- Пишіть гостьові пости на авторитетних ресурсах (з dofollow, якщо редакція дозволяє) — це дає якісний лінк з високого HC-домену.

- Розміщуйте репозиторії або гайди на GitHub — посилання на ваш сайт там часто індексуються і мають хороший HC.

- Беріть участь у Reddit, Stack Overflow, форумах — корисні відповіді з посиланням на ваш матеріал часто залишаються.

Один-два таких природних посилання з топових хостів дають набагато більше для HC, ніж 50 спамних. Ризик штрафу від Google і втрата довіри в графі Common Crawl — не варті сумнівних схем.

Як перевірити HC мого сайту?

Є два рівні перевірки:

- Локальний HC (ваш сайт як мікро-граф): Експортуйте sitemap.xml, побудуйте граф у NetworkX (приклад коду в розділі 6) і розрахуйте nx.harmonic_centrality(). Це покаже, наскільки добре структурований ваш сайт всередині.

- Глобальний HC (у вебі): Завантажте файли cc-main-*-host-ranks.txt.gz з останнього Web Graph Common Crawl (наприклад, січень 2026). Знайдіть свій домен через grep або Python-скрипт. Якщо домен відсутній — значить HC ще низький і сайт не в пріоритеті.

Для швидкої оцінки використовуйте CC Index Server: https://index.commoncrawl.org/ — введіть ваш домен і перевірте, скільки сторінок потрапило в останній краул.

Чи впливає HC на Google ранжинг?

Прямо — ні, бо Google використовує PageRank, BERT, MUM та інші власні моделі, а не HC Common Crawl. Але опосередковано — дуже сильно, і ось чому:

- Краща структура (плоска ієрархія, кластери) → вищий HC → частіший краулінг CCBot → більше сторінок індексується → більше шансів на зовнішні посилання від інших сайтів.

- Це створює цикл: більше якісних зовнішніх посилань → вищий PageRank → краще ранжування в Google.

- Плюс: якісна структура та перелінковка суттєво покращують E-E-A-T і семантичне розуміння контенту, що критично для AI Overviews, Gemini та інших ШІ-фіч Google. Детальніше про E-E-A-T у SEO та як його посилити — читайте в статті Що таке E-E-A-T у SEO.

- А про те, як Google розуміє природну мову через штучний інтелект (BERT, MUM, семантичний пошук) і як структура сайту допомагає в цьому — розбір тут: Як Google розуміє природну мову через штучний інтелект.

Тому оптимізація під HC — це не заміна класичного SEO, а його потужне посилення в еру ШІ-пошуку.

Чи змінюється HC щомісяця?

Ні, не щомісяця — Common Crawl оновлює повні Web Graphs щоквартально (зазвичай кожні 3–4 місяці). Останній на лютий 2026 — це дані за листопад 2025 – січень 2026.

Але частіші оновлення відбуваються в краулах CC-MAIN (щомісяця або частіше), і якщо ваш сайт активно змінюється, то в наступному графі ваш HC може покращитися вже через 2–3 місяці. Тому регулярні оновлення контенту та посилань — це спосіб тримати HC в топі.

✅ Висновки

Harmonic Centrality — це не просто ще одна метрика. Це нова математика видимості в еру, коли ШІ-моделі тренуються на архівах Common Crawl, а не на кліках у Google. Вона показує, наскільки ваш сайт «близький» до колективного розуму інтернету: короткі шляхи в графі = частіший і глибший краулінг CCBot = вищий шанс потрапити в тренувальні дані GPT-5, Gemini 2.0, Claude 4 та LLaMA.

Я бачу це на практиці: сайти з DR 5–10, але з плоскою структурою, кластерами та 2–3 якісними зовнішніми посиланнями, отримують CCBot частіше, ніж деякі авторитетні ресурси з глибокою ієрархією. Це означає, що ваш контент стає частиною відповідей ШІ без переходу на сайт — саме те, що зараз приносить клієнтів.

Головне правило 2026 року: Робіть сайт не просто доступним для людей і Google, а максимально близьким до центру вебу. Кожен додатковий клік, кожне відсутнє посилання в кластері, кожна втрачена можливість на GitHub або Reddit — це +1 до середньої відстані в графі, і ваш сайт стає «далі» від ШІ-розуму.

Якщо ви пройшли весь цикл (від pillar page про епоху ШІ-краулерів до цієї статті), у вас уже є повний план:

- Перейдіть на плоску ієрархію ≤3 кліки

- Побудуйте тематичні кластери з сильною перелінковкою

- Додайте breadcrumbs і JSON-LD

- Оновлюйте контент регулярно

- Працюйте над природними посиланнями з топових хостів

- Перевіряйте результат у NetworkX та CC Index

Почніть з перших двох пунктів — вони дають найбільший приріст HC за найменших зусиль. Через 1–2 краули ви побачите різницю в логах сервера.

Це не теорія — це те, що вже працює в Європі та США для сайтів у ніші веб-розробки, туризму, e-commerce та послуг. Ваш вибір: залишитися на периферії вебу чи стати частиною центру.

Наступний крок: Поверніться до головного хаба «Епоха ШІ-краулерів: Як CCBot перетворює ваш сайт на базу знань для GPT-5 та Gemini» або перейдіть до кластера .